La Inteligencia Artificial (IA) está por todas partes. Gracias a todo este mecanismo oculto, una máquina es capaz de aprender hasta 1.000 millones de parámetros y usarlos luego para dar la respuesta acertada en cuestión de segundos. ¿Cómo la hace? La explicación no siempre es evidente y eso es lo que genera desconfianza a muchos de los usuarios. Este es el objetivo que persiguió Marc Schœnauer, principal investigador en el laboratorio de Investigación Informática en el Instituto Nacional de Investigación en Ciencia de la Informática y Matemáticas Aplicadas (INRIA), en París, cuando se unió al proyecto europeo TRUST- IA. El programa, de cuatro años, se dedica a lo que se llama la inteligencia artificial explicable y empieza en octubre gracias a una financiación de hasta cuatro millones de euros por parte del Consejo Europeo de la Innovación de la Comisión Europea.

La base está en las redes neuronales artificiales. Esta red es un modelo computacional inspirado en el cerebro humano. Está constituido por un conjunto de unidades (neuronas artificiales) conectadas entre sí por nodos para transmitir las señales. Estos nodos son puntos de intersección del cual parten algo que se asemeja a ramas de un árbol. De un punto (o nodo), salen dos otras posibilidades, de estas dos, otras cuatro y así, una y otra vez.

“Si hubiese menos nodos, el usuario podría entender mejor el funcionamiento y cómo el algoritmo llega a su conclusión. Nuestro mayor desafío es lograr unos sistemas más sencillos y que puedan, por lo tanto, ser entendidos manteniendo un rendimiento similar a los que existen ahora”, cuenta el experto francés. El proyecto hará un uso extensivo de la programación genética (PG), que optimiza modelos computacionales complejos representados como árboles, con nodos y ramas. Esta imagen ilustra el proceso de decisión de la máquina, por ejemplo. De este punto, salen dos otras posibilidades, de estas dos, otras cuatro y así, una y otra vez, hasta llegar a la solución final.

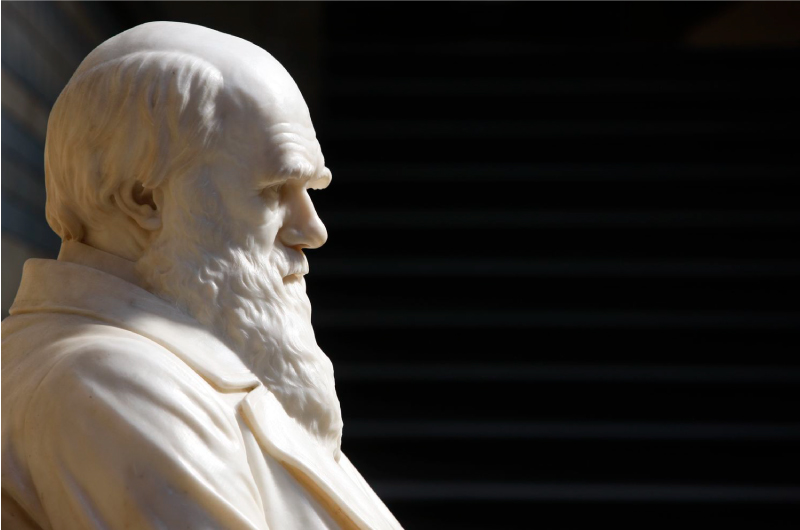

La idea es inspirarse de la biología y de la teoría de la evolución de Charles Darwin para construir de manera gradual redes cada vez mejores y hacer un mayor seguimiento del proceso. “Por ejemplo, el árbol que representa la segunda ley de movimiento de Newton se representaría con un nodo (producto) y dos hojas (masa y aceleración), dando salida a la fuerza. Con estas reglas sencillas podemos entender lo que pasa”, comenta Schœnauer. La Segunda Ley de Movimiento de Newton establece (de forma muy resumida) que la aceleración que adquiere un cuerpo es proporcional a la fuerza neta aplicada sobre el mismo.

Ventajas

Gracias a la PG, se crean algoritmos evolutivos: estos algoritmos harán mutaciones o posibles cruces con la población actual, de cuya mezcla saldrán los que mejor comportamiento presenten. Estos mejores se guardarán para hacer la siguiente población, y así sucesivamente. “Es una caricatura de la resistencia del más resistente, pero esa es la idea. Vamos a intentar reproducir los resultados de la red neuronal con unos modelos probablemente mucho más comprensibles”, precisa el científico francés.

Este método tiene ventajas, pues permite que intervenga directamente el usuario. En general, un algoritmo se programa con un objetivo preciso y la persona que vaya a interaccionar con él no tiene influencia en al resultado. La PG permite, sin embargo, pedir la opinión a la gente y que valore cuáles de las opciones son las más comprensibles. “Esto permite al algoritmo actuar en función del usuario para que tengan mayor confianza en el sistema. Además la buena explicación depende de a quién nos dirigimos”, argumenta el investigador que lleva años buscando cómo mejorar eso y esperando esa financiación.

Otra de las virtudes de este tipo de algoritmos evolutivos es su gran capacidad para solventar múltiples objetivos a la vez, pues encuentra la mejor compensación frente a todos los conflictos que se generan. Los expertos de este nuevo programa quieren que los resultados sean los mejores y a la vez comprensibles. Sin embargo, si solo se basa en algunos parámetros para aumentar su legibilidad, es posible que no tome en cuenta todas las variables posibles. ¿Cómo lograr entonces un equilibro entre sencillez y exactitud? “Eso queremos saber. Eso buscamos”, contesta Schœnauer.

Aplicaciones a la vida real

Para llevar a cabo el programa de investigación y confirmar su respuesta a esa pregunta, el equipo se centrará en tres casos concretos aunque sus algoritmos tengan como objetivo un uso generalista: los tratamientos médicos, el envío de productos a domicilio y el consumo de energía de los edificios. “Estos tres ámbitos nos van a ayudar a llevar a cabo el proceso a los datos del mundo real. No solo queremos un buen rendimiento de media, pero queremos también evitar malos escenarios”, comenta Gonçalo Figueira, coordinador del proyecto e investigador del Instituto de Ciencia, Tecnología e Ingeniería de Sistemas y Computación de Portugal (INESC TEC). “Podremos prevenir los problemas y el impacto negativo de la IA si somos capaces de explicar estos modelos. De lo contrario, sería difícil predecir su comportamiento y confiar en ellas”, afirma antes de detallar el programa.

En primer lugar, quieren incidir en la medicina, uno de los ámbitos que se ve muy afectado por el progreso de la tecnología y la llegada de la IA: desde los diagnósticos hasta saber cuándo es mejor tomar el tratamiento o hacer la cirugía. En este último punto, TRUST-IA va a actuar como una herramienta para predecir. Su uso se destinará a un tratamiento específico para un cáncer concreto y con pacientes con sus propias características. “La idea es que el algoritmo anuncie cuándo es el mejor momento para dar el tratamiento e indique qué se debe hacer para cada caso particular”, describe Figueira. Un poco en la misma línea, otro caso de uso utilizará los modelos de IA para pronosticar la demanda de energía en los edificios. El objetivo final es simular el uso y el precio.

Además de predecir, los modelos matemáticos generados por la IA también pueden prescribir. Es el tercer caso en que se probará el proyecto: la entrega de mercancías. La intención es que el usuario se beneficie de un mejor servicio. Para ello, deberá buscar las opciones más eficientes desde el punto de vista operativo, lo que servirá tanto para evitar retrasos como para que el cliente reciba el producto en el mejor momento y al mejor precio.

Barreras y transparencia

Para Schœnauer, que las IA llegará a controlarnos en un futuro próximo, es una fantasía. “Siempre hay un hombre detrás del programa”, recuerda. El experto insiste, sin embargo, en que debemos asegurarnos de que no suceda y empezar a proteger al ciudadano introduciendo restricciones y controles en los algoritmos para que sean éticos y evitar que dañen al ser humano. Además, “el hecho de ser inteligente no significa que pueda tomar el control sobre nosotros”, opina Figueira. Los programas están hechos para hacer algo concreto, muy específico y son más inteligentes que el ser humano, quizás, en una sola cosa, así como jugar al ajedrez, o calcular en medio segundo la regla de tres. En definitiva, el objetivo de todo esto es hacer una Inteligencia Artificial transparente que deje ver qué ocurre en las zonas ocultas de su red y qué camino emprende para dar una sola y única solución.

Richard Benjamins, co-fundador de OdiseIA, el Observatorio español para el Impacto Ético y Social de la Inteligencia Artificial, opina que el tema de este nuevo proyecto europeo es muy pertinente debido al creciente uso de la IA en muchos sectores. “La IA explicable tiene especial importancia cuando las decisiones tomadas por los sistemas tienen un impacto significativo en la vida de las personas, como ocurre con en el diagnóstico médico, la inscripción en los servicios públicos, la solicitud de préstamos, entre otras”. Cuenta Benjamins que el año pasado, la agencia de defensa de los Estados Unidos (DARPA, por sus siglas en inglés) lanzó un gran proyecto al respecto, por lo que un proyecto europeo es “más que bienvenido”. El experto de OdiseIA precisa que, sin embargo, no todos los algoritmos de IA son cajas negras, y que ya existen algunas técnicas parecidas para hacer más transparentes los que sí lo son, como el SHAP (SHapley Additive exPlanations) y el LIME (Local Interpretable Model-Agnostic Explanations). “Más allá de ello, este es definitivamente un proyecto importante”, concluye.